فایل robots.txt چیست و چه تاثیری در سئو دارد؟

فایل robots.txt یک فایل متنی است که با استفاده از آن به ربات های گوگل میگوییم که چه صفحاتی را کرال و ایندکس کنند و چه صفحاتی را ایندکس نکنند. همان طور که میدانید، برای اینکه وب سایت شما بتواند در نتایج گوگل ظاهر شود، گوگل باید آن را بخزد و فهرست کند. اجازه دهید برای درک بهتر فایل robots.txt یک مثال بزنیم.

فرض کنید وارد یک اداره بزرگ چند طبقه میشوید و جایی را هم بلد نیستید. مدیران این سازمان هم میداند که مراجعه کنندگان جایی را نمیشناسند. به همین منظور یک باجه اطلاعات ایجاد کردهاند و فردی را در آنجا مسئول راهنمایی مراجعه کنندگان قرار داده اند. اگر این سازمان، یک راهنما نداشته باشد، شما مجبور هستید برای رسیدن به آدرس اتاق مورد نظر خود، کل اداره را زیره رو کنید و کلی پله هارو بالا پایین بروید.

فایل robots.txt هم نقش راهنما را در وب سایت ها دارد، با این تفاوت که به جای کاربران، راهنمای ربات های گوگل هستند. ربات های گوگل هرکاری که دوست دارند انجام میدهند و هر کجایی که دلشان بخواد سرک میکشند.

خب پس با این اوصاف صفحات، پوشه ها و فایل هایی که دوس نداریم ایندکس شوند را باید چکار کرد؟ اینجاست که شما با ساختن فایل robots.txt میتوانید به گوگل پیشنهاد دهید که چه صفحاتی را ایندکس کنند و چه صفحاتی را ایندکس نکند.

فایل robots.txt چیست؟

فایل robots.txt یک سند متنی است که در ریشه یک وبسایت قرار میگیرد و وبمستران باید خودشان آن ایجاد کنند. هنگامی که ربات های گوگل میخواهند صفحات سایت را بررسی و کرال کنند، ابتدا این فایل را میخوانند. این فایل به ربات های گوگل مجوز میدهند که کدام صفحات، پوشه ها و فایل ها را بررسی و خزش کنند و چه صفحاتی را نباید بررسی و ایندکس کنند.

مثلا در مواقعی که نمیخواهید گوگل صفحات بی ارزش و تکراری سایت را ایندکس کند، میتوانید از این روش استفاده کنید. دقت داشته باشید که داشتن فایل robots.txt الزامی نیست، ولی با نبود آن گوگل بدون هیچ محدودیتی تمام سایت را بررسی میکند.

ربات چیست؟

ربات ها نرم افزارهایی هستند که به دلایل گوناگونی به صفحات مختلف سایت سر میزنند و به صورت خودکار تمام صفحات سایت را بررسی میکنند.

ربات های بسیار زیادی در اینترنت میچرخند که ربات های موتورهای جستجوگر گوگل مهمترین آنها هستند. این ربات ها روزانه چندین بار به صفحات سایت شما سر میزنند و اگر یک سایتی خیلی بزرگ باشد و روزانه محتواهایی بسیار زیادی در آن منتشر شود؛ ممکن است ربات های گوگل چند صد هزار بار به آن سایت سر بزنند. یا به عبارتی میشه گفت در سایت هایی بزرگ مثل فارس نیوز همیشه ربات های گوگل حضور دارند و در حال بررسی کردن صفحات هستند.

هر کدام از ربات ها وظایف خاصی را بر عهده دارند. مثلا googlebot که مهمترین ربات گوگل است، صفحات جدید سایت را پیدا کرده و آنها را بررسی و ایندکس میکند.

ربات های گوگل هر کجایی که دوست داشته باشند، میروند و هر چیزی را که بخواهند در سرور خود ذخیره کرده و به مخاطبان نمایش میدهند. توجه کنید که ما با استفاده از فایل robots.txt نمیتوانیم به ربات های گوگل دستور دهیم! بلکه به آنها پیشنهاد (تقاضا) میکنیم که به کدام صفحات ما مراجعه نکنند.

پس متوجه شدید که ربات های گوگل نه تنها ضرری برای سایت ندارند، بلکه اگر از آن درست استفاده کنید، خیلی هم برای سایت شما مفید و ارزشمند هستند و در سئو سایت هم تاثیر خوبی دارند. برخی از مهمترین ربات های گوگل که بهتر است آنها را بشناسید:

- Googlebote: رباتی که صفحات جدید منتشر شده در اینترنت را کشف کرده و آنها را بررسی و ایندکس میکند.

- Googlebote image: وظیفه این ربات پیدا کردن تصاویر و بررسی کردن آنها است.

- Googlebote video: رباتی که ویدیوها را پیدا کرده و آنها را بررسی میکند.

- Googlebote news: وظیفه این ربات ایندکس کردن سایت های خبری میباشد.

هر یک از این ربات ها به صورت مداوم تمام صفحات را بررسی میکنند، که شما میتوانید با نوشتن یک دستور از خزیدن آنها جلوگیری کنید.

چرا باید فایل robots.txt داشته باشم؟

شما میتوانید از روش های مختلفی برای جلوگیری از ورود ربات های گوگل به سایت و مدیریت آنها استفاده کنید، که یکی از این روش ها ساختن فایل robots.txt است. هر وب مستری میتواند این فایل را با توجه به ساختار و استراتژی سایت خود بنویسد، تا برای وبسایت خود مفید و ارزشمند باشد.

- با استفاده از این فایل میتوانید بودجه خزش سایت خود را مدیریت کنید و آن را افزایش دهید.

- هنگامی که در سایت صفحات تکراری دارید، میتوانید از این فایل استفاده کنید.

- میتوانید صفحاتی مثل پنل کاربری، عقد قراردادها و غیره را که دوس ندارید در دسترس عموم قرار بگیرد، از دسترس گوگل خارج (disallow) کنید.

- فایل ها، تصاویر و پوشه هایی که دوست ندارید ربات های گوگل آنها را ایندکس کنند را ببندید.

- با کمک این فایل میتوانید نقشه سایت را به ربات های گوگل معرفی کنید.

- میتوانید خزش ربات ها را در سایت خود محدود کنید.

دستورات فایل robots.txt

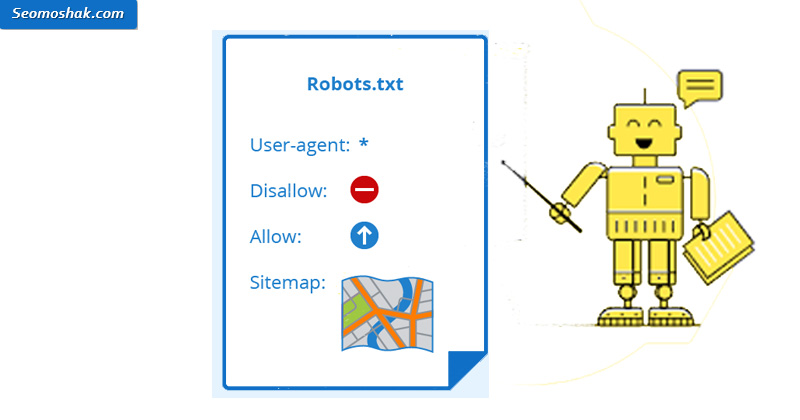

برای مدیریت این فایل 4 دستور العمل مهم و کاربردی وجود دارد:

- user-agent: برای مشخص کردن نوع ربات استفاده میشود.

- Disallow: بخش هایی که ربات ها اجازه بررسی و ایندکس کردن آنها را ندارد از این دستور استفاده میکنیم.

- Allow: بخش هایی که ربات ها مجاز به بررسی کردن آنها است، از Allow استفاده میکنیم.

- sitemap: از این دستور برای قرار دادن آدرس نقشه سایت استفاده میکنیم.

1- دستور user-agent:

با استفاده از این دستور مشخص میکنیم که دقیقا چه ربات های میتوانند به سایت دسترسی داشته باشند و چه ربات هایی نمیتوانند به سایت وارد شوند.

مثلا اگر بخواهید برای ربات های گوگل دستوری بنویسید، نام ربات گوگل را مینویسید:

user-agent googlebot

یعنی این دستور فقط برای ربات گوگل است.

همچنین اگر بخواهید دستوری برای تمام ربات های اینترنت بنویسید، از علامت (*) در مقابل user-agent استفاده میکنید:

* :user-agent

این دستور تمام ربات های موجود در اینترنت را شامل میشود.

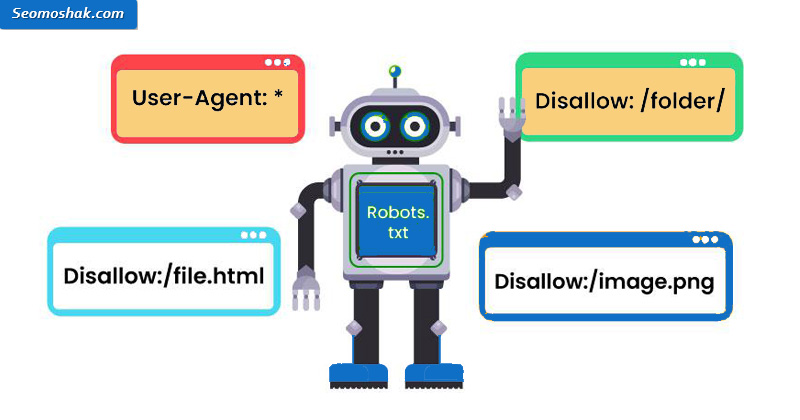

2- دستور disallow:

بعد از مشخص کردن ربات های مدنظر خود، وقت آن رسیده که دستور صادر کنید. صفحات، فایل ها، پوشه ها و تصاویری را که نمیخواهید ربات های گوگل به آنها دسترسی داشته باشند، با دستور disallow از دسترس خارج میکنید.

دقت کنید که روت دامین نباید نوشته شود و بعد از اسلش باید بنویسید. اگر میخواهید چند آدرس را disallow کنید، هر کدام را باید در خط جداگانه بنویسید.

به مثال زیر توجه کنید.

* :user-agent

/Disallow: /wp-admin

/Disallow: /refer

/Disallow: */feed

Disallow: /Picture

disallow: /blog

در واقع با نوشتن دستورات بالا به تمام ربات های موتورهای جستجوگر میگویید که این پوشه ها و صفحات را ایندکس نکند.

مثلا فرض کنید تمام تصاویر سایت شما در پوشه Picture قرار دارد، بنابراین شما با نوشتن دستور Disallow: /Picture به گوگل میگویید که تمام تصاویر داخل پوشه picture را ایندکس نکند.

3- دستور Allow:

این دستور به معنای اجازه دادن است. این دستور به شما کمک میکند تا استثنا قائل شوید، یا به عبارتی شرط بگذارید. مثلا اگر بخواهید آدرس یک صفحه ای را برای گوگل قابل دسترسی کنید، در صورتی که دایرکتری مادر آن را با دستور disallow از دسترس گوگل خارج کرده اید، از دستور Allow باید استفاده کنید.

به مثال زیر توجه کنید:

* :user-agent

/Disallow: /sample

Allow: /sample/sub2

این دستور به ربات ها می گوید، با این که پوشه sample از دسترس گوگل خارج شده است، ولی اجازه دسترسی به پوشه sub2 را دارد.

4- نقشه سایت (sitemap)

به کمک این دستور میتوانید نقشه سایت را در اختیار ربات های گوگل قرار دهید. کافیست در مثال زیر به جای برند سئو موشک نام دامنه خود را قرار دهید. توجه کنید که قرار دادن نقشه سایت الزامی نیست، ولی بهتر است برای درک بهتر خزنده های گوگل از این دستور استفاده کنید.

Sitemap: https://seomoshak.com/sitemap_index.xml

محدودیت استفاده از دستورات robots.txt

دستوراتی که در این فایل نوشته میشود، برای تمام ربات های اینترنت یکسان نیست. با توجه به دستورالعمل موتورهای جستجو ممکن است برخی از آنها، مثلا ربات های گوگل از این دستورات پیروی کنند و برخی از آنها مانند بینگ یا یاندکس از این دستورات پیروی نکنند.

نکته: اگر یک صفحه را محدود کرده باشیم و به گوگل اجازه دسترسی ندهیم، باز هم احتمال دارد گوگل آن را بررسی و ایندکس کند. چرا که ما هیچ وقت نمیتوانیم به گوگل دستور بدهیم.

فایل robots.txt کجا قرار دارد؟

برای مشاهده فایل robots.txt سایت خود و همچنین سایت دیگران، کافیست در انتهای آدرس url سایت، عبارت robots.txt/ را وارد کنید، مانند:

https://www.example.com/robots.txt

با نگاه کردن به فایل ربات دیگر سایت ها میتوانید از آنها الگوبرداری کرده و در سایت خود استفاده کنید.

آموزش ساخت فایل robots.txt

برای تنظیمات و نوشتن فایل robots.txt باید به root وبسایت خود مراجعه کنید. ابتدا وارد هاست سایت خود شوید، بر روی file manager کلیک کرده و سپس پوشه public_html را انتخاب نمایید، فایل robots.txt را پیدا کنید و بر روی آن کلیک راست کرده و گزینه ویرایش را بزنید.

اگر این فایل در قسمت روت سایت شما وجود ندارد، کافیست در همین قسمت یک فایل ایجاد کنید و اسم آن را robots.txt قرار دهید (توجه کنید که تمام حروف باید کوچک باشد)، سپس دستورات لازم را در آن بنویسید و ذخیره کنید (هنگام نوشتن دستورات به حروف کوچک و بزرگ آنها نیز باید توجه کنید).

همچنین میتوانید دستورات را در یک فایل notepad بنویسید و سپس آن را در فایل robots که ایجاد کرده اید، قرار دهید و ذخیره کنید.

یک نمونه ساده و پرکاربرد فایل robots.txt که در اکثر وب سایت های وردپرسی استفاده میشود، برای شما قرار داده ایم.

* :User-agent

/Disallow: /wp-admin

Allow: /wp-admin/admin-ajax.php

/Disallow: */feed

Disallow: /readme.html

Sitemap: https://example.com/sitemap_index.xml

نکات مهم هنگام نوشتن فایل robots.txt

- نام فایل حتما باید robots.txt باشد، نمیتوانید نام دیگری برای آن بنویسید.

- آدرس فایل حتما باید در ادامه نام دامنه باشد.

- حتما باید فرمت فایل txt باشد. نمیتوانید از فرمت دیگر مانند XML، html و غیره استفاده کنید.

- استفاده از فایل robots.txt اجباری نیست.

بهینه کردن فایل robots.txt برای سئو

برای تاثیر گذاری بیشتر فایل robots.txt در سئو باید به چند نکته توجه کنید.

آدرس هایی که disallow میکنید خزیده نمیشوند، حتی لینک هایی که در این آدرس ها قرار دارند به نوفالو تبدیل میشوند. پس اگر میخواهید لینک هایی که داخل این آدرس ها قرار دارند فالو باشند، نباید از دستور disallow برای این صفحات استفاده کنید.

اگر صفحاتی را که با استفاده از دستور disallow از دسترس گوگل خارج کرده اید، نباید به این صفحات لینک داخلی بدهید. چرا که گوگل با استفاده از این لینک ها به صفحه مورد نظر رسیده و آن را ایندکس میکند.

اگر اطلاعات فایل robots.txt را تغییر یا ویرایش کرده اید، و میخواهید سریعتر در دسترس گوگل قرار بگیرد، بهتر است آن را مجددا در سرچ کنسول سایت خود ثبت کنید.

نحوه تست فایل robots.txt در سرچ کنسول

برای اینکه تست کنید فایل ربات در دسترس است یا نه! میتوانید از ابزار تست کننده در سرچ کنسول استفاده کنید. اگر سایت خود را به سرچ متصل کرده اید و بر روی لینک بالا کلیک کنید به صفحه ای منتقل میشوید که از شما میخواهد نام سایت مورد نظر خود را انتخاب کنید. بعد از انتخاب نام دامنه مورد نظر به صفحه ای هدایت میشوید که در آن فایل robots.txt را میتوانید مشاهده نمایید.

نتیجه گیری:

با نوشتن و قرار دادن فایل robots.txt میتوانید به ربات های گوگل کمک کنید تا راحت تر بفهمند، کدام صفحات را ایندکس کنند و کدام را نادیده بگیرند و ایندکس نکنند. به عبارتی این فایل دارای سه دستور مهم است که با نوشتن هر کدام از آنها دستوراتی به ربات های گوگل میدهیم و آنها را راهنمایی میکنیم.

ایجاد فایل robots یکی از مهمترین بخش های سئو تکنیکال است که با استفاده از آن میتوانید، صفحات بی کیفیت و بی اهمیت را از دسترس گوگل خارج کنید، تا بودجه خزش سایت خود را افزایش دهید یا به عبارتی بودجه خزش را مدیریت کنید.

در حال ثبت رای

در حال ثبت رای

دیدگاهتان را بنویسید